Lumiere,谷歌惊人的视频突破

著名商业教授Scott Galloway打赌,2024年将是谷歌的人工智能之年。

现在,他们推出了Lumiere,这是从文本到视频的一个巨大突破,是当今生成式人工智能中最困难的任务之一,也可能是它一旦实现的影响中最大的未达到的里程碑,因为它是一项可能永远改变好莱坞、YouTube或CGI等大型行业的技术。

现在,谷歌已经让我们更接近了一步,因为他们的人工智能视频合成方法不仅是革命性的,而且还展示了令人难以置信的视频质量和广泛的惊人技能,如视频输入/输出,图像动画和视频样式,使其成为该领域的新参考。

但它是如何生成视频的呢?

看起来像魔法,但其实不是,让我们揭开它的秘密。如果你想了解更多关于人工智能的相关内容,可以阅读以下这些文章:

2024年每个开发人员都需要掌握的生成式人工智能技能

Google的Gemini AI模型:揭开人工智能的未来

世界上最好的人工智能模型:谷歌DeepMind的Gemini已经超过了GPT-4!

我尝试了50种人工智能工具,以下是我的最爱

永恒的问题

毫无疑问,在所有数据形式中,视频是最难用人工智能生成的。

然而,考虑到视频只是图像的串联,称为帧,以一定的帧速率每秒显示(fps越高视频越平滑),构建文本到视频(T2V)系统的逻辑路径是脱离文本到图像模型(T2I),如DALL-e或稳定扩散。

然而,T2V增加了一层额外的复杂性:时间。

换句话说,生成多个帧是不够的(你可以用T2I模型生成尽可能多的帧),但它们必须随着时间的推移保持一致。

换句话说,如果你正在生成一个关于狮子的视频,你必须确保狮子在所有帧中看起来都很相似。

事实证明这是一个巨大的问题,因为在多个帧之间保持结构的复杂性迫使AI视频非常短,而且它们往往会展示人工制品,视觉缺陷,如下面这个AI生成的视频中突然出现的橙色。

这些不一致的原因在于这些模型是如何建立的,我们很快就会解释Lumiere是如何彻底改变这种方法的。

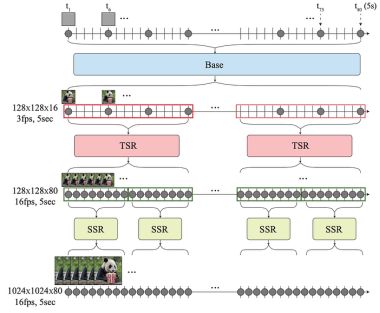

最初,视频合成过程包括三个步骤:

T2I先验生成了一组跨越整个视频持续时间的关键帧。

接下来,几个TSR(时间超分辨率)模型用一组新帧“填补”关键帧之间的空白。例如,如果两个关键帧是一个严肃的人和同一个人微笑,则TSR模型生成生成微笑手势的完整中间帧集。

然后,一组ssr(空间超分辨率)将采用低分辨率帧并对其进行升级以提高视频质量,因为大多数T2V模型在低分辨率像素空间(或者,在某些情况下,在矢量空间,如稳定扩散)中工作,以获得更高效和更便宜的过程。

最后,SSR的输出被“缝合”在一起,你就得到了视频。

最重要的是,人工智能视频只是使用一个图像生成器,并训练它分批生成某种程度上一致的图像,然后将它们拼凑在一起。

这是可行的。

就像如果你正在拍摄一个演员,在草图的中途,他打破了角色,你试图通过强迫他进入特定的位置来完成草图的其余部分,避免失去第一部分一样,无论你编辑得多好,剪辑都是可见的。

此外,由于这个过程涉及到使用几种不同类型的模型,这些模型并不总是共享相同的经验和表示(它们如何构思概念),这使得它非常容易出错。

考虑到这些限制,视频生成似乎还没有完全准备好。但有了谷歌Lumiere,我们可能会看到一些大事情的开始。

空间,时间和多重扩散

T2V作为其图像对应体,多为扩散模型。

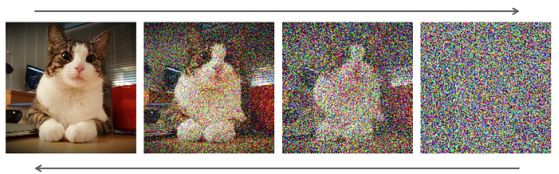

扩散模型是一种人工智能系统,它通过去噪过程学习将数据的噪声分布映射到目标分布。

通俗地说,它们取一个有噪声的图像和一个文本条件(你想要的最终结果是什么),然后逐渐从图像中去除噪声,直到你得到结果。

把扩散的过程想象成一个大理石块,就像米开朗基罗一样,雕刻出多余的大理石来“挖掘”雕像。

但是,Google没有遵循我们前面描述的标准过程,而是通过创建一个STUnet找到了另一种方法。

那是什么呢?

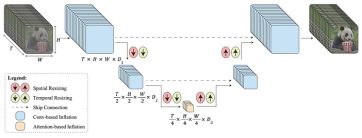

UNet是一种对图像进行下采样、处理和生成一组新图像的体系结构。

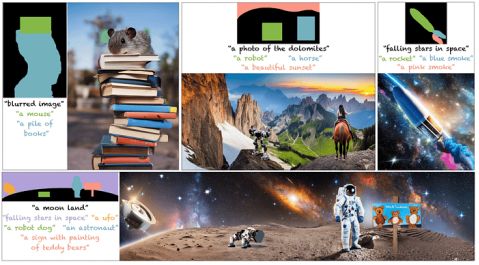

换句话说,它取一组有噪声的样本(如上图所示为模糊图像),并生成一组新的高质量图像,这些图像之间也相互连贯,从而生成视频。

要做到这一点,在应用卷积来处理图像(了解它看到的是什么)时,它会对图像进行下采样(使它们更小)。

一旦它们被压缩到足够的程度,它现在就会应用注意力(就像ChatGPT对文本序列所做的那样,但是会对图像的压缩表示进行关注,以便更好地掌握图像中出现的概念,比如熊猫),然后将它们上采样回像素空间,留给你所需的图像。

然而,图像也包括时间卷积和注意力,这意味着它们压缩了时间。

换句话说,空间卷积和注意力集中于处理和确保生成的图像代表用户要求的内容,而时间卷积和注意力则确保图像在整个集合中保持一致。

这听起来很抽象,但是STUnet所做的不仅仅是理解每一帧代表什么,还有不同帧之间的关系。

换句话说,它不仅要捕捉到熊猫的画面,还要捕捉到熊猫在一段时间内应该做什么动作。

生成过程是“时间感知”的事实允许Lumiere一次创建视频中的所有帧(而不是我们之前讨论的通常的关键帧+级联帧填充),因此STUnet只需要专注于捕获帧的语义并将其升级为实际视频。

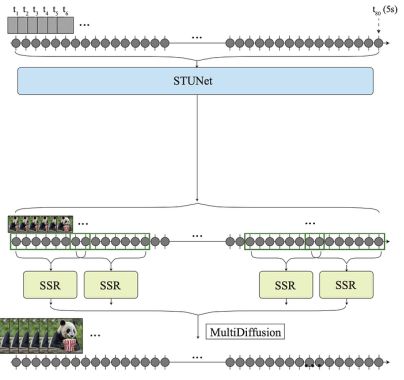

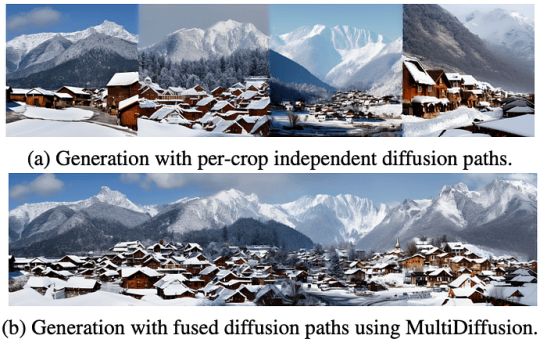

然而,由于内存限制,你仍然需要许多SSR模型来提升图像,这意味着在最后仍然有一些“拼接”在进行。

因此,为了避免每个SSR的放大输出之间的不一致性,他们应用了MultiDiffusion (Bar-Tal et al, 2023)。

这样做的目的是通过使用MultiDiffuser来确保不同生成帧批次之间的一致性。

用非常简单的术语来说,MultiDiffuser允许在一帧上同时进行多个图像生成过程。

例如,你可以创建“模糊图像”,同时对图像的补丁应用并行代,例如在图像的特定部分绘制“鼠标”或“一堆书”。

关键的直觉是,MultiDiffuser可以确保,无论你通过单独的扩散过程在这些图像片段中生成什么,它们都与整体一致。

技术提示:这是通过在标准代的基础上应用额外的代来实现的,这些代必须遵守一个额外的目标函数,该函数测量并行代的数据分布之间的“差异”。

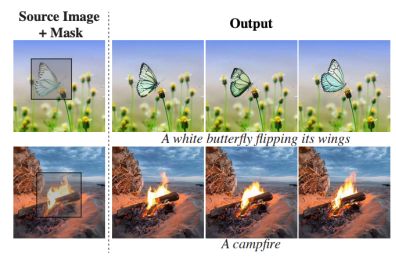

换句话说,MultiDiffuser允许你在保留原有结构的同时尽可能地在原有结构上“绘制”新的东西。

因此,该组件确保了需要拼接在一起的视频的几个帧批次,你可以重新创建不同SSR模型输出之间的边界,以便它们是一致的,确保段之间的平滑过渡。

你可以把MultiDiffuser想象成使用Photoshop来“smoothen out”SSR模型高档的不同补丁的边界,就像视频编辑器想要确保在批次中看不到任何剪切一样。

它可以使图像的部分动画化。

绘制新的物体和概念:

你可以在这里查看其他惊人的功能:查看由Lumiere生成的视频https://lumiere-video.github.io/。

视频的新时代

有了Lumiere,世界可以清楚地看到视频生成、编辑和动画等领域的未来。

很快,任何人都将有能力创建令人印象深刻的视频,从零开始在任何时间,创造一个新的世界的可能性。

尽管取得了令人印象深刻的成绩,但我们只是看到了冰山一角。

感谢阅读!你还可以订阅我们的YouTube频道,观看大量大数据行业相关公开课:https://www.youtube.com/channel/UCa8NLpvi70mHVsW4J_x9OeQ;在LinkedIn上关注我们,扩展你的人际网络!https://www.linkedin.com/company/dataapplab/

原文作者:Ignacio de Gregorio

翻译作者:过儿

美工编辑:过儿

校对审稿:Jason

原文链接:https://pub.towardsai.net/lumiere-googles-amazing-video-breakthrough-158587d68dfe