世界上最好的人工智能模型:谷歌DeepMind的Gemini已经超过了GPT-4!

本文选自The Algorithmic Bridge,一个旨在弥合人工智能与人类之间差距的教育项目,今天我们一起学习如何应对已经到来的未来。

近期,谷歌和谷歌DeepMind宣布了他们期待已久的人工智能模型Gemini。关于它的工作效果,仍然没有太多的实际反馈,但报告的性能非常出色。如果你想了解更多关于人工智能的相关内容,可以阅读以下这些文章:

软件工程师:2023年让你减少繁忙工作的8大最佳人工智能工具!

人工智能取代人工之前要问的4个问题

如何一眼识别人工智能生成的图像!

一个新的人工智能野兽苏醒了!

这篇文章是对我们目前所掌握的信息的一个快速概述(分为易于浏览的部分),以及我对所读内容的第一印象(尚未测试该模型)。在接下来的几天里,我将更深入地了解Gemini可以做什么,它是如何构建的(希望如此),它是如何工作的,以及它对人工智能的未来意味着什么。

下面是大纲:

- Gemini规格,大小(Ultra, Pro, Nano)和可用性。

- Gemini Ultra比GPT-4更好。

- Gemini具备本地多模态功能。

这是我从现有信息中得出的第一印象。

Gemini规格,大小(Ultra, Pro, Nano)和可用性

Gemini系列有三种大小:Ultra、Pro和Nano。以下是技术报告中关于Gemini大小及其规格部分的摘要。

技术报告:https://storage.googleapis.com/deepmind-media/gemini/gemini_1_report.pdf

Gemini Ultra是实现最先进(SOTA)基准测试并超越GPT-4基准测试的版本(我们很快就会看到)。它被设计为在数据中心上运行,所以你不会把它安装在你的家用电脑上。它仍在红队的安全审查中,但将于2024年初在谷歌聊天机器人巴德高级版上使用。

Gemini Pro与GPT-3.5相当(但并不总是更好),它针对“成本和延迟”进行了优化。如果你不需要最好中的最好,而且成本有限,那么Pro可能是比Ultra更好的选择(就像GPT-3.5是免费的ChatGPT,对于大多数任务来说,比每月支付20美元的GPT-4要好)。Gemini Pro已经在170个国家(不包括欧盟/英国)的Bard上提供英文版本(“它最大的升级”)。谷歌将在以后扩展到其他国家和语言。

Gemini Nano是针对设备的型号。谷歌没有透露Ultra和Pro的参数,但我们知道Nano分为两层,Nano 1 (1.8B)和Nano 2 (3.25B),分别用于低内存和高内存设备。Gemini Nano内置在谷歌Pixel 8 Pro上,Pixel 8 Pro将成为一款全面增强人工智能的智能手机。这是超级siri移动助手的开始。Gemini还将“在我们的更多产品和服务中使用,如搜索、广告、Chrome和Duet AI”,但没有具体说明具体的规模和时间。

所有Gemini模型都有一个32K的上下文窗口,明显小于最大的Claude 2 (200K)和GPT-4 Turbo (128K)。很难说上下文窗口的大小是最优的(显然,这取决于任务),因为据报道,如果上下文窗口的大小太大,模型往往会忘记很大一部分上下文知识。据报道,Gemini模型“有效地利用了它们的上下文长度”,这可能是对这种类型的检索失败的隐式引用。

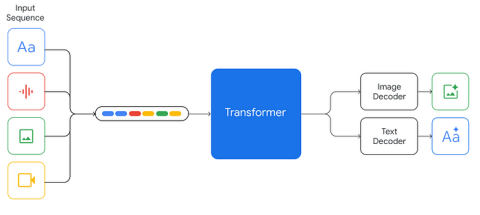

正如你所期望的那样,考虑到今天人工智能领域普遍存在的对接近性的偏好,我们对训练或微调数据集一无所知(除了数据集包含“来自web文档、书籍和代码的数据,并包括图像、音频和视频数据”),或者模型的架构(除了它们是“构建在Transformer解码器之上”和“通过架构和模型优化的改进而增强”)。

这么说有点搞笑,但我们得等到Meta发布下一款手机才能知道更多。一个开源的Llama 3——如果它与GPT-4和Gemini的性能进行比较的话——将会揭示这些模型是如何构建的,以及它们是如何训练的。

最后要说明的是,谷歌DeepMind也在Gemini的基础上发布了AlphaCode 2。它比它的前身AlphaCode多解决了1.7倍的问题,并且比85%的参赛者表现得更好。这主要与竞争性编程相关,但在这里值得一提。

Gemini Ultra比GPT-4更好

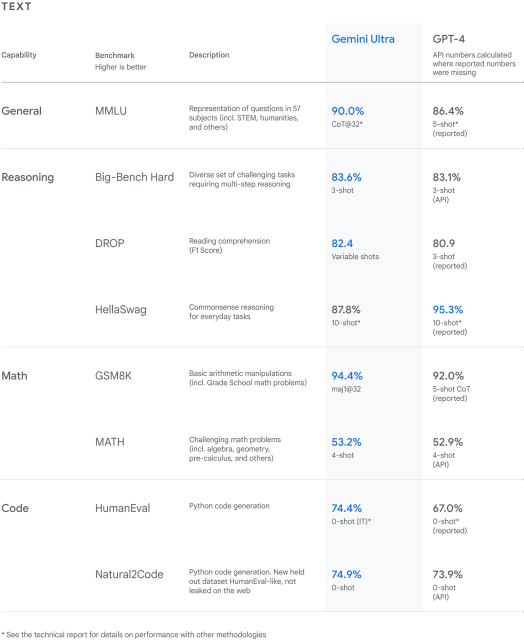

无论在科学还是商业层面,这都可能是最重要的消息。近一年来,人工智能模型首次超过了GPT-4。Gemini Ultra在32项“广泛使用的学术基准”中有30项达到了SOTA。

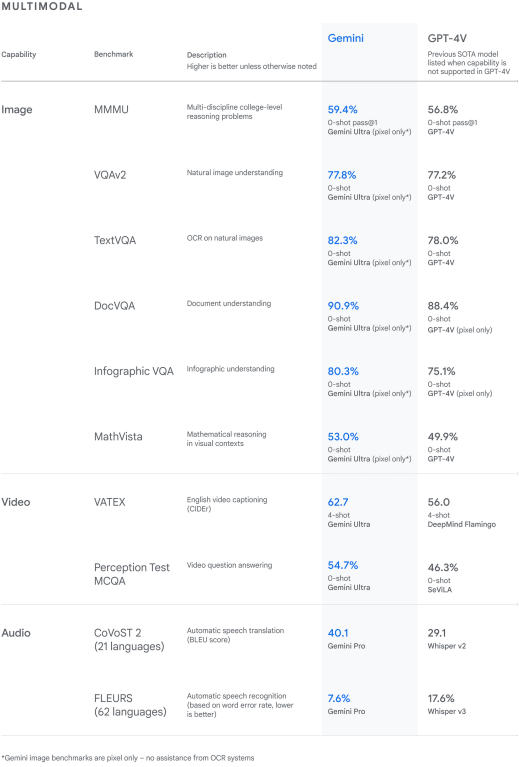

Gemini Ultra的得分为90.0%,是第一个在MMLU(大规模多任务语言理解)上超越人类专家的模型,该模型使用数学、物理、历史、法律、医学和伦理学等57个学科的组合来测试世界知识和解决问题的能力。Gemini Ultra在新的MMMU基准上也达到了最先进的分数59.4%,该基准由跨越不同领域的多模态任务组成,需要进行缜实的推理。

Gemini Ultra在18项基准测试中有17项超过GPT-4,其中包括MMLU (90% vs 86.4%)

如果你想从现实世界的测试中了解更多Gemini的能力(例如,推理和理解,解决数学和编码问题等),我建议你看看谷歌DeepMind互动博客帖子的视频(https://deepmind.google/technologies/gemini/#introduction),以及首席执行官Sundar Pichai在X上发布的全面演示(这两个都非常值得一看,可以更好地理解上面的数字意味着什么)。

我认为这已经足够展示了谷歌在Gemini性能方面的公关能力。我将在这里留下技术报告结论的摘录,以防你有错误的印象,认为Gemini已经克服了所有困扰现代人工智能系统的问题——幻觉和高级推理仍然没有解决:

尽管语言模型具有令人印象深刻的功能,但我们应该注意到语言模型的使用存在局限性。对于由语言模型产生的“幻觉”,需要继续进行研究和开发,以确保模型的输出更可靠和可验证。尽管语言模型在考试基准测试中表现出色,但它们在需要高级推理能力的任务上仍然存在困难,如因果理解、逻辑推理和反事实推理。

Gemini具备本地多模态功能

这里要注意的单词是“native”,但让我们先回顾一下多模态,与只接受文本作为输入并生成文本作为输出的语言模型相比,多模态AI可以处理不同的数据类型。

用具体的术语来说,多模态在人工智能中是什么样子的,在光谱的最弱的一面,我们有视觉+语言。DALL-E 3(以文本为输入,制作图像为输出)和GPT-4(以文本或图像为输入,制作文本)是弱多模态的突出例子。最强大的一面仍未被探索,但原则上,人工智能可以获得人类拥有的每一种感觉模式(甚至更多),包括那些提供行动能力的模式(例如,机器人的本体感觉和平衡感)。

到目前为止,Gemini是多模态光谱中最强的模型,包括文本、代码、图像、音频和视频。

摘自技术报告:

https://storage.googleapis.com/deepmind-media/gemini/gemini_1_report.pdf

Gemini模型经过训练,可以适应文本输入与各种各样的音频和视觉输入交织在一起,比如自然图像、图表、屏幕截图、pdf和视频,并且它们可以产生文本和图像输出。

多模态需要对世界有更深入的了解。一些人认为,当语言模型试图通过处理文本数据中的统计相关性来预测下一个单词时,它们会发展出内部世界模型,但是,如果这是真的,这些模型是非常有限的。随着科学家们建立的模型能够解析更多的信息模式,它们的内部表征也会变得更加丰富——在极端情况下,它们会与我们的模型相匹配。

然而,有两种不同的方法可以构建多模式AI。这就是Gemini独特的多模式设计发挥作用的地方。第一种方法以前已经探索过很多次,它包括添加能够处理不同输入/输出的不同模块。这在表面上起作用,但并没有为系统提供编码更丰富的多模态世界模型的方法。以下是谷歌DeepMind首席执行官Demis Hassabis在博客中所写的内容:

到目前为止,创建多模态模型的标准方法包括为不同的模态训练单独的组件,然后将它们拼接在一起,大致模拟其中的一些功能。这些模型有时可以很好地执行某些任务,比如描述图像,但在更概念性和复杂的推理方面会遇到困难。

第二种方式,大概只有Gemini采用了,需要从头开始构建多模式的人工智能系统。与GPT-4不同,Gemini从一开始就对多模式数据进行了预训练,然后进行了微调。下面是Hassabis对这种新方法的看法:

我们设计Gemini是天生的多模式,从一开始就在不同的模式上进行了预先训练。然后我们用额外的多模态数据对其进行微调,以进一步改进其有效性。这有助于Gemini从一开始就无缝地理解和推理各种输入,比现有的多模式模型要好得多,而且它的能力几乎在每个领域都是最先进的。

第二种多模态方法更类似于人类大脑如何通过与多模态世界的多感官接触来学习。如果有一种方法可以达到真正的通用智能(或者至少是人类水平的智能,与通用智能不同),那就是通过这种默认的多模态。视频演示清楚地展示了原生多模态所赋予的令人印象深刻的功能。

接下来的步骤是规划和机器人:

人工智能公司开发出能够看、听、说、创造、移动、计划,并利用外部信息和知识做出合理决策的系统,以实现目标,这只是时间问题。谷歌DeepMind的Gemini和OpenAI的Q*大概就是朝着这个方向迈出的一步(特别是通过学习和搜索解决规划问题)。

谷歌DeepMind首席执行官Demis Hassabis向来自Platformer的Casey Newton证实,他们正在“认真考虑基于代理的系统和规划系统。”在与《连线》杂志的Will Knight的对话中,他重申了将Gemini与机器人技术相结合的类似愿景:“要实现真正的多模式,你需要包括触摸和触觉反馈……将这些基础模型应用于机器人技术有很大的希望,我们正在大力探索这一点。”

请随意将这些评论视为谷歌DeepMind在2024年计划做什么的高级路线图。

我对现有信息的第一印象

谷歌已经实现了其隐含的承诺:Gemini在几乎所有基准测试中都优于GPT-4。就其本身而言,它可能花费了数百万美元,但却物有所值。这是四年来第一次有人超越OpenAI。无论如何,在我们过度炒作Gemini之前,我们应该等待谷歌在2024年初宣布Bard Advanced,并将其与ggt -4 Turbo进行测试,以决定哪一个更好。也许现在应该问的问题是:由于其(未知的)架构,Gemini能否随着时间的推移比GPT更快地改进?当然,我们不知道这个问题的答案。

值得注意的是,如果你仔细观察基准评估报告中的数据,你会发现Gemini最多只比GPT-4高出几个百分点(记住,GPT-4在2022年完成了训练)。我认为这证明了用目前的方法做出更好的模型是非常困难的,而不是证明谷歌DeepMind的研究人员比OpenAI的研究人员“更差”——这两家公司拥有世界上最好的人工智能人才,所以这是人类现在在人工智能方面所能做的顶峰。他们是否应该开始探索其他范例?我觉得事情正在发生变化,我们即将告别基于转换器的语言模型的霸权。

也许更值得注意的——即使并不令人惊讶——是谷歌DeepMind对亲密关系的拥抱(就像OpenAI和Anthropic一样)。他们没有分享任何关于训练或微调数据集的价值,也没有分享任何关于架构的价值。这表明,从严格意义上讲,Gemini与其说是一个科学项目,不如说是一个商业产品。这本身并不坏(取决于你是研究人员还是用户),只是不是DeepMind的全部内容。就像微软在2019年收购OpenAI迫使他们转向生产和产品市场匹配战略一样,谷歌也在同样程度上利用DeepMind来实现这一目标。

回到科学上来。接下来是规划、代理和机器人。我预测,在接下来的几个月或几年中,我们将看到在这些更大的挑战上的进展比我们在语言建模上看到的要慢(记住Moravec的悖论)。Hassabis认为Gemini将展示出我们之前从未见过的能力,但与OpenAI已经拥有的相比,我不认为这些能力会成为真正的突破(从整体上来看)。Hassabis和牛顿谈过这个问题,所以我仍然感到兴奋:“我认为我们会看到一些新的功能。这是”Ultra”测试的目的之一。我们还处于测试阶段,要对其进行安全检查、责任检查,同时也要看看如何对其进行微调。”

最后,尽管Sundar Pichai将此次发布称为“Gemini时代”的开端,但我认为谷歌的真正价值在于,重新找回了人们对他们的部分信任,因为这家拥有800名员工的初创公司年复一年地把他们甩在后面。这是谷歌对所有声称他们无法交付的人的报复。这是它对OpenAI以及围绕ChatGPT和GPT-4的无可挑剔的营销的报复。我们将看看它是否对他们同样有效,更重要的是,它能持续多久。

感谢阅读!你还可以订阅我们的YouTube频道,观看大量大数据行业相关公开课:https://www.youtube.com/channel/UCa8NLpvi70mHVsW4J_x9OeQ;在LinkedIn上关注我们,扩展你的人际网络!https://www.linkedin.com/company/dataapplab/

原文作者:Alberto Romero

翻译作者:过儿

美工编辑:过儿

校对审稿:Jason

原文链接:https://albertoromgar.medium.com/the-best-ai-model-in-the-world-google-deepminds-gemini-has-surpassed-gpt-4-1ee07f84d2ff