10种 Regression 回归分析的方法, 到底该用哪个?

到底该在什么情况下使用哪种回归对数据进行分析呢? 到目前为止一共存在着数百种回归的类型。 这篇文章包含了数据科学家和其他分析从业者的概述,帮助你根据不同情况来决定使用哪种回归分析。 这里有很多引用的文章都被我完善地总结到我写的英文版数据科学丛书里面了,需要的小伙伴可以自行索取~ https://www.datasciencecentral.com/profiles/blogs/my-data-science-book

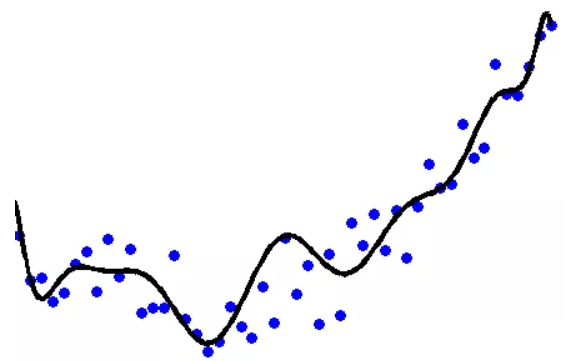

线性回归Linear regression

最早的回归类型,设计于250年前; 设计人员可以很容易地由人类对小数据进行计算。 可用于插值,但不适用于预测分析; 当应用于现代数据时 , 存在许多缺点 ,例如,对极值和互相关性(在变量域和观察域中)的敏感性,并且可能导致过度拟合。 好一些的解决方案则是进行分段线性回归,尤其是对于时间序列数据。

逻辑回归Logistic regression

当因变量为二进制(成功或失败的机会,例如,对于新测试的药物或信用卡交易)时,广泛应用于临床试验,评分和欺诈检测。 遭遇着与线性回归相同的缺点(不稳定,依赖模型),而且当计算逻辑回归系数时会涉及使用复杂的迭代,数值不稳定的算法。 转换因变量(对数转换)之后,可以通过线性回归很好地近似。 某些版本(Poisson泊松或Cox回归)已设计用于非二进制响应,分类数据(分类器),有序整数响应(年龄组)甚至连续响应(回归树)。

岭回归Ridge regression

线性回归的一种更强大的版本,它对回归系数进行了限制,以使得回归系数更加自然,较少几率造成过度拟合并且更易于解释。

套索回归Lasso regression

类似于岭回归,但自动执行变量的约简( 允许回归系数为零 )。

生态回归Ecologic regression

如果你的数据分为几个相当大的核心层、组或区域,则每个层都执行一次回归。 在这种情况下,要当心大数据的诅咒 :如果执行数百万次回归,则某些模型将会完全错误,而最好模型的将被人为拟合优度的噪音所遮盖:如果要尝试识别极端事件和因果关系 (全球变暖,罕见疾病或极端洪水模型)这将会是一个大问题。

异常空间中的回归Regression in unusual spaces

例如:检测陨石碎片是否来自同一天体,或对可口可乐配方进行逆向工程。

逻辑回归Logic regression

当所有变量均为二进制时,通常在评分算法中使用。 它是逻辑回归的一种专门化、更可靠的形式(用于欺诈检测,其中每个变量均为0/1规则),其中所有变量都已归类为二进制变量。

贝叶斯回归Bayesian regression

这是一种受惩罚的似然估计器 ,因此有点类似于岭回归:比传统的线性回归更灵活,更稳定。 它假设你具有回归系数和误差项的先验知识-放宽了误差必须具有正态分布的假设(误差必须仍然独立于所有观察值)。然而,在实践中,先验知识被转换为人工(共轭)先验-该技术的弱点。

分位数回归Quantile regression

与极端事件结合使用。

LAD回归LAD regression

类似于线性回归,但使用绝对值(L1空间)而不是平方(L2空间),更稳定。

刀切回归 Jackknife regression

这是一种新型的回归,也用作常规聚类和数据约简技术。 它解决了传统回归的所有弊端。 它为回归问题提供了一种近似但非常准确的稳健解决方案,并且可以与相关和/或非正态的“独立”变量(例如,根据具有多种模式的混合模型分配的数据)一起使用。 它可以很好地近似线性回归,但是它更健大,可以在违反传统回归假设(非相关变量,正态数据,均方差)的情况下运行。

注意:Jackknife回归与1982年发布的Bradley Efron的Jackknife、bootstrap和其他重新采样技术无关。

其他解决方案

- 可以使用我们的特征选择算法执行数据约简

- 将多种技术融合在一起以改善回归,聚类或分段算法始终是一个好主意。 这种混合的一个例子是隐藏决策树

- 诸如种族之类的独立自变量有时使用多个(二进制)伪变量进行编码

原文作者:Vincent Granville

翻译作者:Tony Sun

美工编辑:过儿

校对审稿:Dongdong

原文链接:https://www.datasciencecentral.com/profiles/blogs/10-types-of-regressions-which-one-to-use