GenAI能做和不能做的五件事

很难相信,ChatGPT推出至今还不到一年,我们已经看到生成式人工智能(GenAI)席卷全球。从大型语言模型(LLM)到用于图像生成的稳定扩散模型,这项新技术所能做的事情确实非常了不起。一位朋友向我描述说,这是他们第一次感受到人工智能是有形的,就好像我们在科幻小说中梦想的东西现在已经成为现实。

自然而然,这让商业领导者开始思考GenAI能够对他们的业务流程进行怎样的转变。当然,你可以用GenAI做很多很酷的事情,但也存在一些误解,商业领导者应该谨慎对待。这篇文章的重点是与你分享GenAI可以做的一些核心事情,同时也减少了人们对它不能做的事情的期望。如果你想了解更多关于ChatGPT的相关内容,可以阅读以下这些文章:

作为数据分析师,我一直在使用ChatGPT Vision

如何用ChatGPT取代谷歌?

ChatGPT越来越傻了吗?我们一起聊聊“AI Drift”

掌握ChatGPT的反向提示

能力1:GenAI可以总结大量信息

也许我在各个行业中听到的最经典的用例之一是使用大型语言模型(LLM)的能力,特别是将大量信息浓缩成更易于理解的内容。例如,你可以从会议中获取转录的对话,并使用GenAI将信息总结为几个关键的要点。此外,你可以拿一份大的法律文件,让LLM提取最相关的信息。当然,你应该始终谨慎地验证LLM的输出是否正确,但这可以在许多不同的业务环境中节省大量时间。我非常希望随着时间的推移,这一技术能够在越来越多的行业中得到应用。

缺点1:GenAI无法对任何事情抱有确定性。

也许人们对LLM最大的误解之一就是认为他们会思考。实际上,LLM只是简单的单词预测机器,尽管这些模型非常精确,几乎可以模拟真正的意识。由于LLM是根据单词之间的概率进行操作的,所以它永远无法真正确定最终的输出。然而,具有讽刺意味的是,它总是会产生非常自信的输出。我们把这些自信但虚假的陈述称为幻觉。

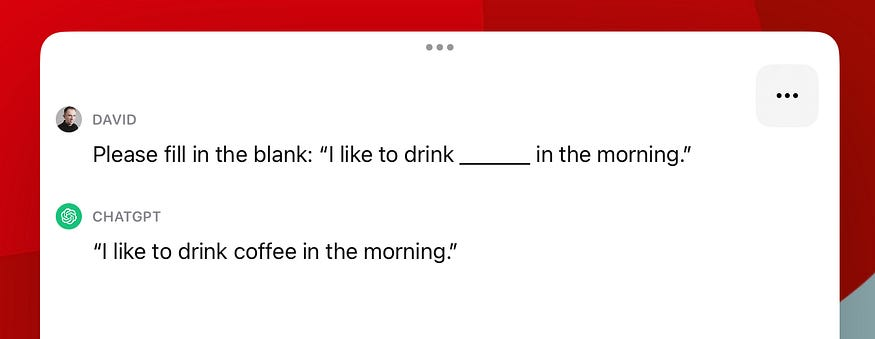

考虑下面的句子:“我喜欢在早上喝______。”如果你作为人类来回答这个问题,你可能会思考。我们可以相对确定的是,空白处是某种液体,但它究竟是什么液体呢?咖啡?茶?水?就像人类一样,LLM也不能确定答案;然而,与人类不同的是,LLM不会告诉你,“我不知道。”相反,它会自信地给出一个答案,但你和我都知道LLM不可能确定答案。让我们看看ChatGPT是如何尝试填写这个空白的。

正如你所看到的,ChatGPT自信地将空白填充为“coffee”,但它没有给出可能填充错误的指示。再次,我们把这种过于自信的“猜测”称为幻觉,但我们可以通过下一个方法来减少这些幻觉……

能力2:GenAI可以通过增强上下文给出更明智的答案。

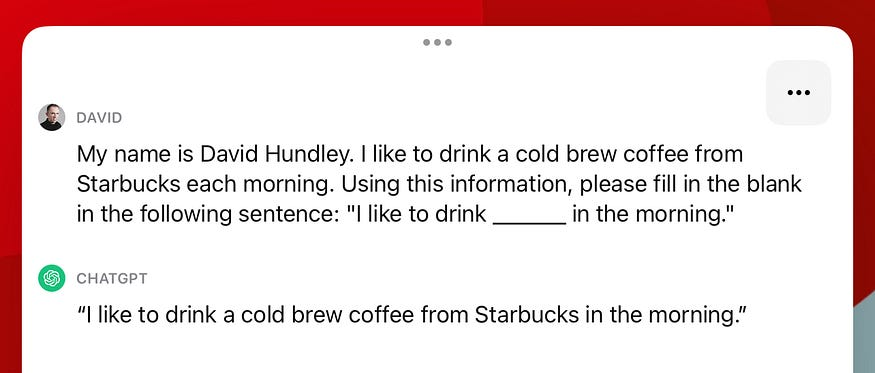

在前面的观点中,我们注意到LLM不能特别确定如何填写以下句子的空白:“我喜欢在早上喝______。”然而,我们可以通过提供额外的上下文来增加LLM的知识。在GenAI社区中,我们将其称为检索增强生成(RAG)。如果我们让LLM在没有任何额外上下文的情况下填写上面的空白,它肯定会给我们一个答案,但这个答案可能是幻觉。现在,假设我们给了LLM一些额外的上下文。我们可以修改我们输入到LLM中的内容如下:

我叫David Hundley。我喜欢每天早上喝一杯星巴克的冷咖啡。使用这些信息,请在下面的句子中填空:“我喜欢在早上喝______。”

现在,LLM已经提供了一些非常具体的上下文,它可以准确填写空白。在ChatGPT中进行测试,你将看到我们收到了完全正确的答案。

当然,这并不能使LLM的输出完全准确无误。记住,LLM是评估单词之间的概率。在RAG过程中,我们只是增加了产生更正确答案的输出的概率。这并不能将确定性的概率提高到100%,但它确实可以帮助你!

缺点2:GenAI无法自己发现新事物

虽然RAG过程可以在很大程度上帮助GenAI提供更精确的答案,但RAG过程并不是自动的。换句话说,像LLM这样的GenAI技术不具备自己学习的能力。这些GenAI模型是根据在某个时间点提供给它的信息进行训练的,就好像它的知识被冻结在那个固定的日期一样。当我们向LLM提供额外的上下文时,上下文可以帮助生成更精确的输出,但是这个RAG上下文实际上并没有改变底层模型本身。

我提出这个问题的原因是,虽然RAG过程可能很棒,但并不意味着你可以告诉GenAI自己去寻找那些信息。即使在Bing Chat这样的案例中,LLM看起来是在搜索互联网,但实际上并不是这个模型在爬取互联网。相反,信息是被带给LLM,而LLM则理解带到它面前的信息。我们还没有达到Skynet那样的超级智能水平,这些人工智能模型可以自己解决问题。

能力3:GenAI可以成为出色的编码助手

请注意这一点的措辞。我在这一点上特意使用了“可以”这个词。人们已经找到了利用LLM进行编码的方法,而且可以明确地说,LLM对于帮助编写代码非常有用。无论是自动填充常见任务还是帮助调试错误,GenAI在编码方面都是一个非常有用的工具。

问题是,LLM在这项任务中并不完美。除了受限于在某个时间点上的信息训练之外,我个人的经验是,当被要求为非常微妙的情况编写代码时,LLM往往会产生相当多的幻觉。记住,LLM的效果取决于你所提供的上下文。如果你的错误源于与你的特定系统相关的某些事情,那么LLM无法了解系统的细节,因此最终会产生幻觉答案。这并不是说GenAI对编写代码没有帮助,但我更愿意把它看作是一个助手。

缺点3:GenAI无法确定另一段内容是否由GenAI创建

这是研究人员反复争论的问题之一。事实上,OpenAI曾经发布过一个工具来帮助教师确定一份作业是否是使用ChatGPT创建的。最终,OpenAI收回了这个工具,如果你了解这些GenAI解决方案的基本数学和架构,我认为我们很快就会到达一个不可能实现的点。

想想目前市场上最先进的LLM,包括OpenAI的GPT-4和Anthropic的Claude 2。这些LLM可以生成极其类似人类的输出,这是因为底层架构能够以惊人的精确度评估单词之间的概率。仔细研究真实意识和人工意识之间的界限,人们不禁会想,人类的语言是否也可以作为单词之间的概率来预测。在这一点上,LLM和人类的最终结果在概率上是无法区分的,所以没有工具能够明确地说,“这是由GenAI创建的;这是由人类创建的。”

综上所述,不要轻信一个声称可以区分AI生成内容和非AI生成内容的工具。也许对于更原始的GenAI解决方案来说,它可以在某种程度上进行评估,但我们可以说像GPT-4这样的LLM已经超过了那个可区分性的点。

能力4:GenAI可以得到其他软件流程的帮助

虽然大多数人更熟悉通过ChatGPT这样的用户界面与LLM交互,但几乎所有主要的GenAI参与者都通过API等提供编程解决方案。这意味着我们可以将GenAI技术集成到新的和现有的软件流程中。事实上,大多数GenAI初创公司正是这么做的。具体来说,许多GenAI初创公司正在使用OpenAI或Anthropic等提供商的API作为后端“引擎”来支持其GenAI需求。(这就是为什么你也应该小心选择与之合作的公司,因为他们可能在幕后与第四方互动!)

再次强调,GenAI应该始终针对幻觉进行调节。虽然GenAI可以生成代码片段来执行诸如从数据库查询特定信息之类的任务,但我个人永远不会依赖LLM来完成此类任务。因为我们不能百分之百确定代码是正确的,所以依赖GenAI这样做是不明智的。这并不是说你永远不应该将GenAI纳入到你的软件系统中!仍然存在一些很好的用例,你可以在编程解决方案中以一种既有益又谨慎的方式利用GenAI。

缺点4:GenAI不能正确地引用自己的源信息

这是一个我经常被问到的问题,如果你一直密切关注这个问题,你就会明白为什么这是不可能的。虽然LLM是在某个时间点上基于信息进行训练,但它并没有把单词之间的所有概率都与特定的来源联系起来。LLM只存储了所谓的权重和偏差。在不深入研究LLM的底层架构的情况下,LLM本质上是由大量的数学运算组成的,在训练时,这些权重和偏差会被更新,以更紧密地与训练的信息保持一致。(实际上,如果我要深入解释LLM的架构,你会惊讶地发现,数学是非常基本的,以至于LLM可以做尽可能多的事情,这看起来很神奇!)

这就是LLM的全部内容。没有直接联系到源信息,所以如果你要求它引用自己的来源,你最多只能得到一种幻觉。事实上,我相信像ChatGPT这样的LLM已经被微调,说它不可能透露其来源,我认为这是一种比幻觉更好的反应。但收到幻觉反应并非不可能。有一个臭名昭著的场景,一位律师使用LLM引用了一个法律案件中的消息来源,结果发现引用的消息来源是幻觉,最终是虚假的。小心别掉进同样的陷阱!

能力5:GenAI是增加你知识的一种极好方式

就像GenAI可以成为编写代码的好助手一样,GenAI也可以成为任何知识任务的好助手。我个人使用像ChatGPT这样的LLM作为一般知识问题的“搜索引擎”。例如,它在提供单词的定义方面非常出色,并且在你追加问题时可以提供更详细的答案。这就像和一位知识渊博的朋友交流一样。虽然互联网搜索引擎可以提供最新和最相关的信息,但对话流程的来回交流是简单搜索引擎无法比拟的。

当然,到这个时候我应该不用再提醒你要小心幻觉了。虽然LLM可能对古罗马等历史事件和地点更有帮助,但如果你问它今天的天气如何,你肯定会得到一个幻觉的答案。如果它确实提供了一个正确的答案,那也是因为LLM以RAG方式被增强,而不是LLM自己能够推导出这些信息。此外,要特别注意在数学问题上使用LLM。记住,这些LLM是为了寻找单词之间的概率而训练的,所以当数学问题出现时,不会进行任何数学计算。最近几个月,像ChatGPT这样的热门LLM似乎被增强了,可以更好地处理数学问题,但目前还不清楚它们是如何做到的。无论如何,我还是会尽量避免用LLM做复杂的数学问题。

缺点5:GenAI无法取代你的工作

是的,这是每个人心中都存在的一个大问题!说实话,GenAI可以用来减少人类劳动力,但绝对还没有达到它会消除大多数人工作的地步。如果你仔细阅读了这篇文章中关于信息检索的部分,你就会发现GenAI最大的“缺陷”:GenAI无法主动自我学习。GenAI无法和你的CEO交谈,也无法揣摩他们的想法。GenAI 无法深入你的大脑来理解你在想象中构建的网站的所有微妙细节。从这个角度来看,我认为GenAI就像一个完全天真的天才:你可以让它做很多事情,但你必须明确且非常具体的告诉它,以获得最理想的结果。

接下来的问题自然是:人工智能会发展到能够做到这些事情的地步吗?我们将这种下一阶段的超级智能称为通用人工智能(AGI),这就是人工智能安全倡导者对人工智能进步表示担忧的原因。目标是将人类的利益与人工智能的利益安全地结合起来。不用再深入讨论这个话题了,关键是我们今天还没有到达那个点,而且我们真的不知道什么时候我们会到达“奇点”,即我们到达AGI的那个点。如果你了解人工智能研究的历史,你很快就会发现人类并不擅长预测这一点。

我希望你看完这篇文章后能够更好地了解 GenAI 的用途。这确实是一项令人惊叹的技术,但它并不适用于所有事情。最后我要强调的一点是:GenAI并不是唯一的AI。目前形式的GenAI早在2017年就已经出现了,但我们还有许多其他形式的人工智能,可以适当地完成这项工作。就像你不会租一辆车走10英尺一样,你应该始终尝试选择适合业务需求的解决方案。GenAI只是我们工具箱中的另一个工具,尽管它非常酷!

感谢阅读!你还可以订阅我们的YouTube频道,观看大量大数据行业相关公开课:https://www.youtube.com/channel/UCa8NLpvi70mHVsW4J_x9OeQ;在LinkedIn上关注我们,扩展你的人际网络!https://www.linkedin.com/company/dataapplab/

原文作者:David Hundley

翻译作者:文玲

美工编辑:过儿

校对审稿:Jason

原文链接:https://towardsdatascience.com/five-things-genai-can-and-cant-do-d8117aad82f4