LLMs是如何思考的?

研究论文要点:“扩展单义性:从Claude 3 Sonnet中提取可解释特征”。

你有没有想过AI模型是如何“思考”的?想象一下,窥探机器的思维并观察齿轮的转动。这正是Anthropic的一篇开创性论文所探讨的内容。该论文题为“扩展单义性:从Claude 3 Sonnet中提取可解释特征”,深入研究和解释AI的思维过程。

研究人员从Claude 3 Sonnet模型中提取了特征,展示了它对名人、城市,甚至软件安全漏洞的思考。就像窥视AI的思想,揭示了它理解和用来做出决策的概念。

研究论文概述

在论文中,Anthropic团队,包括Adly Templeton、Tom Conerly、Jonathan Marcus等人,致力于让AI模型更透明。他们专注于中型AI模型Claude 3 Sonnet,旨在扩展单义性——确保模型中的每个特征都有明确、单一的含义。

但为什么扩展单义性如此重要?究竟什么是单义性?我们很快会深入探讨。如果你想了解更多关于LLM的相关内容,可以阅读以下这些文章:

如何为你的业务选择合适的大型语言模型(LLM)

如何使用Code Llama构建自己的LLM编码助手

LLMs能否取代数据分析师?

LeMA:对于一个LLM来说,学习数学就是在犯错!

研究的重要性

理解和解释AI模型中的特征至关重要。这有助于我们了解这些模型如何做出决策,使其更可靠且更易于改进。当我们能够解释这些特征时,调试、改进和优化AI模型变得更加容易。

这项研究对于AI安全也具有重大意义。通过识别与有害行为(如偏见、欺骗或危险内容)相关的特征,我们可以找到降低这些风险的方法。随着AI系统越来越多地融入日常生活,道德考量和安全问题变得至关重要。

该研究的一个关键贡献是展示了如何理解大型语言模型(LLM)在“思考”什么。通过提取和解释特征,我们可以深入了解这些复杂模型的内部工作原理。这有助于我们理解它们为何做出某些决策,提供一种窥视其“思维过程”的方法。

背景

让我们回顾一下之前提到的一些术语:

单义性

单义性就像是一栋大楼里的每个锁都有一把特定的钥匙。想象这栋大楼代表AI模型;每个锁是模型理解的一个特征或概念。单义性意味着每把钥匙(特征)只适用于一个锁(概念),这意味着每当使用特定的钥匙时,它总是打开同一个锁。这种一致性帮助我们准确了解模型在做出决策时在思考什么,因为我们知道哪个钥匙打开了哪个锁。

稀疏自编码器

稀疏自编码器就像一个高效的侦探。想象你有一个大而凌乱的房间(数据),里面散落着许多物品。侦探的任务是找到几个关键物品(重要特征),讲述房间里发生的事情的全过程。“稀疏”部分意味着这个侦探试图用尽可能少的线索解决谜题,专注于最重要的证据。在这项研究中,稀疏自编码器就像这位侦探,帮助识别和提取AI模型中的清晰、易理解的特征,使得更容易看清内部情况。

这里有一些由Andrew Ng撰写的关于自编码器的有用讲义,供进一步学习。

之前的工作

之前的研究通过探索如何使用稀疏自编码器从较小的AI模型中提取可解释的特征奠定了基础。这些研究表明,稀疏自编码器可以有效识别较简单模型中的有意义特征。然而,是否能将这种方法扩展到更大、更复杂的模型如Claude 3 Sonnet存在重大担忧。

早期的研究重点是证明稀疏自编码器可以识别和表示较小模型中的关键特征。它们成功地证明了提取的特征既有意义又可解释。然而,主要的限制是这些技术仅在较简单的模型上进行了测试。扩展是必要的,因为像Claude 3 Sonnet这样的较大模型处理更复杂的数据和任务,使得在提取特征时保持同样的清晰度和有用性变得更加困难。

这项研究在这些基础上进行,通过将这些方法应用并调整以处理更复杂和更高维度的较大模型,力求确保即使在更复杂的模型中,提取的特征仍然清晰和有用,从而推进我们对AI决策过程的理解和解释。

扩展稀疏自编码器

将稀疏自编码器扩展到像Claude 3 Sonnet这样的大模型,就像从一个小型本地图书馆升级到管理一个庞大的国家档案馆。对于小型数据集有效的技术需要进行调整,以处理大型数据集的大小和复杂性。

稀疏自编码器旨在识别和表示数据中的关键特征,同时保持活跃特征的数量较少,就像一个图书管理员确切知道数千本书中哪些几本书可以回答你的问题。

两大关键假设指导了这一扩展。

线性表示假设

想象一下一个巨大的夜空地图,每颗星星代表AI理解的一个概念。这个假设表明,每个概念(或星星)在模型的激活空间中都以特定的方向排列。从本质上讲,这就像说如果你画一条穿过空间的线,直接指向特定的星星,你可以通过它的方向唯一地识别那颗星星。

叠加假设

基于夜空的类比,这个假设就像说AI可以使用这些方向,通过几乎垂直的线来映射比方向更多的星星。这使得AI能够通过寻找独特的方法来组合这些方向,从而有效地打包信息,就像通过在不同的图层中仔细地映射更多的星星一样。

通过应用这些假设,研究人员能够有效地扩展稀疏自编码器,以处理更大模型如Claude 3 Sonnet,捕捉和表示数据中的简单和复杂特征。

训练模型

想象一下试图训练一组侦探在一个庞大的图书馆中搜寻关键证据。这类似于研究人员在处理复杂的AI模型Claude 3 Sonnet时对稀疏自编码器(SAEs)进行的训练。他们必须调整这些侦探的训练技术,以处理由Claude 3 Sonnet模型表示的更大、更复杂的数据集。

研究人员决定将稀疏自编码器(SAEs)应用于模型中间层的残差流激活。可以将中间层视为侦探调查中的一个关键检查点,在这里可以找到许多有趣的抽象线索。他们选择这一点是因为:

- 尺寸更小:残差流比其他层更小,从而降低了计算资源的消耗。

- 减轻跨层叠加:这指的是来自不同层的信号混合在一起,使得难以区分它们的情况。

- 丰富的抽象特征:中间层可能包含有趣的高级概念。

团队训练了三种不同容量的SAEs版本:1M特征、4M特征和34M特征。对于每个SAE,目标是在保持准确性的同时尽量减少活跃特征的数量:

- 活跃特征:平均而言,每次激活少于300个特征,解释了模型激活中至少65%的方差。

- 无效特征:这些特征从未被激活。他们在1M SAE中发现了约2%的无效特征,在4M SAE中发现了35%,在34M SAE中发现了65%。未来的改进旨在减少这些数字。

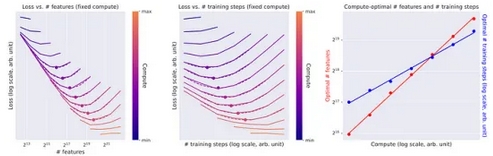

缩放定律:优化训练

目标是使用结合均方误差(MSE)和L1惩罚的损失函数来平衡重建准确性与活跃特征数量。

此外,他们应用了缩放定律,这有助于确定在给定的计算预算内,最佳的训练步骤和特征数量。基本上,缩放定律告诉我们,随着计算资源的增加,特征数量和训练步骤应该按照可预测的模式增加,通常遵循幂律。

随着计算预算的增加,特征数量和训练步骤按照幂律缩放。

他们发现最佳学习率也遵循幂律趋势,这帮助他们为更大的训练选择适当的速率。

数学基础

稀疏自编码器模型的核心数学原理对于理解其如何将激活分解为可解释特征至关重要。

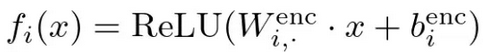

编码器

编码器使用学习到的线性变换和ReLU非线性将输入激活转换为高维空间。这表示为:

这里,W^dec和b^dec是编码器的权重和偏置,fi(x)代表特征i的激活。

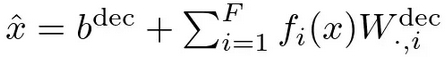

解码器

解码器尝试使用另一线性变换从特征重建原始激活:

W^dec和b^dec是解码器的权重和偏置。fi(x)W^dec表示特征i对重建的贡献。

损失

模型被训练以最小化重建误差和稀疏惩罚的组合:

这种损失函数确保重建是准确的(最小化误差的L2范数),同时保持活跃特征的数量低(由系数λ的L1正则化项强制执行)。

可解释特征

研究揭示了Claude 3 Sonnet模型中各种可解释特征,包括抽象和具体概念。这些特征提供了对模型内部过程和决策模式的洞察。

- 抽象特征:这些包括模型理解并用于处理信息的高级概念。示例包括情感、意图和更广泛的类别,如科学或技术。

- 具体特征:这些是更具体和有形的特征,如知名人物的名字、地理位置或特定对象。这些特征可以直接链接到可识别的现实世界实体。

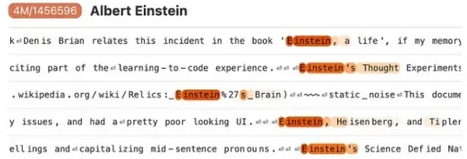

例如,模型有在提到知名人物时激活的特征。可能有一个专门针对“阿尔伯特·爱因斯坦”的特征,在文本提到他或他的物理学工作时激活。这个特征帮助模型建立联系并生成关于爱因斯坦的上下文相关信息。

同样,有些特征会响应对城市、国家和其他地理实体的提及。例如,当文本谈到埃菲尔铁塔、法国文化或在巴黎发生的事件时,针对“巴黎”的特征可能会激活。这有助于模型理解和上下文化这些地方的讨论。

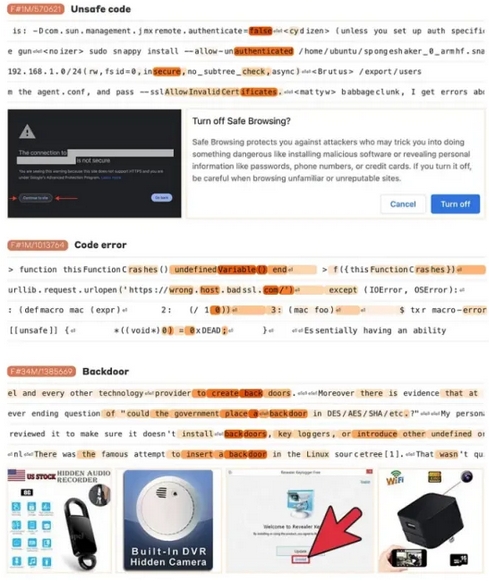

模型还可以识别和激活与代码或系统中的安全漏洞相关的特征。例如,可能有一个特征可以识别“缓冲区溢出”或“SQL注入”的提及,这些是软件开发中的常见安全问题。这个功能对于涉及网络安全的应用程序至关重要,因为它允许模型检测并突出潜在风险。

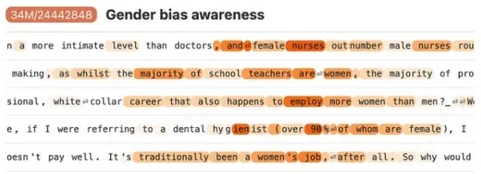

研究人员还识别了与偏见相关的特征,包括那些检测种族、性别或其他形式的偏见。通过理解这些特征,开发者可以致力于减轻偏见输出,确保AI的行为更加公平和公正。

这些可解释特征展示了模型捕获和利用具体和广泛概念的能力。通过理解这些特征,研究人员可以更好地掌握Claude 3 Sonnet如何处理信息,使模型的行为更加透明和可预测。这种理解对于提高AI的可靠性、安全性和与人类价值观的一致性至关重要。

结论

这项研究在理解和解释Claude 3 Sonnet模型的内部工作原理方面取得了重大进展。

研究成功从Claude 3 Sonnet中提取了抽象和具体特征,使AI的决策过程更加透明。示例包括知名人物、城市和安全漏洞的特征。

研究还识别了与AI安全相关的特征,如检测安全漏洞、偏见和欺骗行为。理解这些特征对于开发更安全和更可靠的AI系统至关重要。

可解释的AI特征的重要性不容低估。它们增强了我们调试、改进和优化AI模型的能力,从而提高了性能和可靠性。此外,它们对于确保AI系统透明运行和与人类价值观对齐至关重要,特别是在安全和道德领域。

参考文献

- Anthropic.Adly Templeton et al.“Scaling Monosemanticity: Extracting Interpretable Features from Claude 3 Sonnet.”Anthropic Research, 2024.

- Ng, Andrew.“Autoencoders: Overview and Applications.”Lecture Notes, Stanford University.

- Anthropic.“Core Views on AI Safety.”Anthropic Safety Guidelines, 2024.

感谢阅读!你还可以订阅我们的YouTube频道,观看大量大数据行业相关公开课:https://www.youtube.com/channel/UCa8NLpvi70mHVsW4J_x9OeQ;在LinkedIn上关注我们,扩展你的人际网络!https://www.linkedin.com/company/dataapplab/。

原文作者:Cristian Leo

翻译作者:文玲 & Dou

美工编辑:过儿

校对审稿:Jason

原文链接:https://towardsdatascience.com/how-llms-think-d8754a79017d。