每位AI开发者必备的免费LLM资源!

AI开发者们,欢呼吧!Google已经推出了全新的 Gemini API,并且完全免费。是的,你没看错——没有费用,没有附加条件,只是等待被利用的纯粹AI魔力。

连接数据与AI系统的关键点:LLM管道的设计与实现

是否有一种更易理解、更直观的方式,来系统化理解整个端到端的数据与人工智能系统?答案是:有的!那就是FTI架构。接下来,我们将快速深入探讨FTI架构,并展示如何将其应用于生产级LLM & RAG(Retrieval-Augmented Generation)用例。

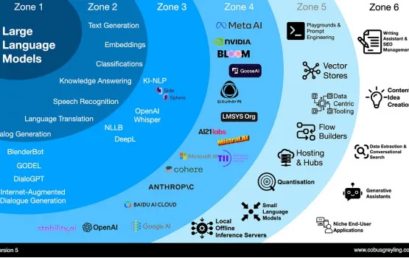

如何在本地运行大语言模型,保护数据隐私(下)

不论是技术专家还是好奇的读者,都能在本文中获得关于本地LLM部署的见解。对于简要概述,非技术读者可以参阅我们的汇总表,而技术读者可进一步了解具体工具和性能评测。

如何在本地运行大语言模型,保护数据隐私(上)

不论是技术专家还是好奇的读者,都能在本文中获得关于本地LLM部署的见解。对于简要概述,非技术读者可以参阅我们的汇总表,而技术读者可进一步了解具体工具和性能评测。

构建可靠AI应用程序的LLM三角原则

本篇文章将详细介绍 LLM 原生应用的三角原则,即通过标准操作程序(SOP)、工程技术选择和上下文数据管理三个要素,构建健壮、有效的 LLM 应用。

运行大型语言模型,需要多少GPU内存?

在使用GPT、LLaMA或任何其他LLM时,了解如何估计所需的GPU内存是至关重要的。无论你是在处理70亿参数的模型还是更大的模型,合理配置硬件以支持这些模型都是关键。接下来,我们将深入探讨数学原理,帮助你估算有效部署这些模型所需的GPU内存。